Actualización: Revisión del Update con los sabandijers

Recientemente grabamos un podcast con los amigos de Quedateconelcambio hablando sobre el update.

MJCachón: Country Manager SISTRIXES y Consultora SEO mjcachon.com

Chuiso: Teamplatino

Prácticamente estoy 100% de acuerdo en todo lo que se dice en el artículo. Me parece que desde hace unos años, aproximadamente desde que Penguin ya no se desplega por separado, esto de las penalizaciones algorítmicas y las penalizaciones manuales es cosa de todos. Esta oleada de acciones manuales no me parece nada excesivamente grave, sin duda no ha sido un ataque directo a los marketplaces que venden enlaces (nos metemos en terrenos fanganosos si Google declara la guerra a estos medios, prensa muy gorda y con mucho poder vende enlaces, esto no es cosa de 4 webmasters «mataos») y es algo que ya ha pasado anteriormente, aunque solía pasar antes de Navidades y Black Friday normalmente. Creo que el hecho de que pasase justo después de la polémica de Posonty ha creado un fenómeno de asociación en la gente, y servido el salseo todo el mundo quiere sangre, pero las pruebas son las pruebas y no hay ningún patrón que indique que sea por enlaces de prensa, tal y como explicas en este artículo. Respecto a la actualización que ataca el contenido de baja calidad no he podido leer mucha información, pero lo único que saco en claro, como siempre, es que aquí lo que yo llamo «Black Hat SEO» es algo que hacemos todos, solo que cada uno lo llamamos de una manera, jeje.

Nadie está a salvo con Google, Google es la mano que nos da de comer y decide cuando comemos, y cuanto. ¿Qué alguien no quiere arriesgarse a sufrir una penalización así? Que no cree enlaces, que no automatice ni una sola tarea en todos sus proyectos y que rece para conseguir la mitad de la mitad de los resultados que obtenemos aquellos que somos conscientes de todo lo que se puede adelantar aprovechando lo que sabemos del algoritmo de Google.

Luis M.Villanueva: Socio y SEO Manager en Webpositer. Socio Seobox, Webpositer Academy, VyL.

En estas ultimas semanas hemos podido ver como google ha desplegado una nueva actualización y ha lanzado 2 oleadas de penalizaciones manuales. Los «CORE UPDATE» como ya todos sabemos son actualizaciones que son prácticamente imposibles detectar un patrón, es más, google cada vez que lanza una nos remite a esta información: https://webmasters.googleblog.com/2019/08/core-updates.html , además cada día son más frecuentes por lo que es una perdida de tiempo analizar al milímetro intentando sacar un patrón concreto como aún siguen haciendo muchos.

En cuanto a las 2 oleadas de penalizaciones manuales me centraré en la de los enlaces que ha sido la que mas he podido analizar. Aquí hay que saber que hay 2 tipos de penalizaciones: «Las que afectan a TODAS las URLs» y «Las que afectan a ALGUNAS URLS» (este mensaje lo podremos ver en la parte inferior de la notificación manual de GOOGLE en nuestro SC), por lo que he podido ver estar en un grupo u otro tiene que ver con la «CANTIDAD» de enlaces arficiales que tenga tu perfil de enlaces respecto a la TOTALIDAD de ese mismo perfil. Cuando hablo de «artificiales» no quiere decir que un enlace artificial sea solo «artificial» porque la web que me enlaza sea SPAM, sino que, por ejemplo no es «afín», el anchor text se ve a leguas que está colocado para manipular el PR, etc. Lo más llamativo es que no hay un patrón común como muchos quieren hacer pensar (no se centra ni en prensa, ni en perfiles, ni en enlaces de foros ni algo tan tan concreto). He visto desde perfiles sin enlaces de prensa penalizados por el uso abusivo de anchor text optimizado, hasta perfiles con solo prensa que han mejorado visibilidad y rankings.

Como resumen, recomendaría revisar periodicamente, (y no digo revisar enlaces que no controlamos, sino también los que controlamos, ya que un enlace que hace un tiempo era bueno hoy puede ser malo) nuestro perfil de enlaces ya que es una practica que SIEMPRE se debe hacer y no veo que esta practica tan relevante se recomiende en ningún blog ni vídeo de muchos expertos en Link Building. Además como recomendación extra, debemos ser capaces de naturalizar nuestros anchor text ya que hoy en día google es capaz de entender mejor (ej: un anchor text de «kw» que antes era «ropa gimnasio» hoy debería ser mucho más especifico, descriptivo y contextualizado, teniendo en cuenta todo lo que rodea ese enlace, tanto delante del anchor como detrás. Ej: «ropa de hombre para ir al gimnasio»).

Esteve Castells: Global SEO Manager Adevinta

JORDI ORDOÑEZ: JordiOB.com e iSocialWeb

- Tematizados

- En sites con tráfico para conseguir no solo el link si no también clics y tráfico

- Con anchors que puedan colar como naturales

LINO URUÑUELA: CoFundador FunnelPunk.com

- No toco el código desde hace años.

- Está con tablas, <table> en vez de <div> para los más jóvenes :p

- No es adaptable

- No tiene versión móvil

- No se actualiza el contenido desde hace ni se sabe

- El contenido no es de gran calidad

- Menos de 1.000 URLs

Pero sube en los últimos Updates, yo lo denomino MAGIA!

Cesar Aparicio: Fundador y consultor SEO de Cráneo Previlegiado y Safecont.com

Se pueden percibir dos vías relacionadas desde el último año y medio a esta parte. La primera, relacionada con el valor como autoridad dentro de la temática en la que se compite y del mismo modo, la segunda, relacionada con el lanzamiento anunciado de BERT (en uso muy probablemente anterior a su anuncio) donde la semántica toma un partido notorio al comprenderse e interpretarse de manera mas exacta el lenguaje natural.

Desde mi punto de vista, las últimas actualizaciones unen ambas corrientes: la relevancia del sitio y sus características «semánticas» de calidad. Del mismo modo que sucedió en el pasado con Panda y Penguin, donde se entrelazaban en un mismo ente (el contenido) varias cuestiones como el contenido en sí y los enlaces, formando un todo. Tanto es así que en el caso de las ultimas notificaciones recibidas en diferentes sitios web, hay cuestiones relacionadas con la «calidad». Tanto un contenido mediocre como enlazado de las mismas características, son mas facilemente detectables tras BERT, y además, los sitios de baja «calidad» detectados por BERT, provocan caídas en la calidad del perfil de enlaces que un sitio recibe.

Un ejemplo de la relación de unos updates con otros, ha quedado señalada con la última actualización del Core (18 de enero) que ha sido, en buena medida, un ajuste del update del Core anterior, del 26 de septiembre. Esto deja patente, como por otra parte es obvio, que todos los updates forman parte de un proceso que se integra en un todo. Y que en definitiva busca ser más preciso en la detección de carencias de calidad.

Visión de iSocialWeb sobre el update

Estamos en días convulsos para la comunidad SEO. Google se ha propuesto hacer de este Enero de 2020 un mes para el recuerdo y está haciendo un homenaje a «los padres fundadores» convirtiendo este mes de Enero en el mes de La purga de las SERPs. Primero de todo vayamos por partes y hagamos un poco de recapitulación.

La Purga de las SERPs… El origen:

Todo empieza una mañana de domingo de hace 7 días, 12 de Enero de 2020 (lo siento Iván y Estela las queja a google :P). Un domingo como hoy en iSocialWeb comenzamos a recibir mensajes de algunos miembros de la comunidad hispana comentando que habían recibido mensajes de penalizaciones manuales derivadas de la generación de enlaces artificiales y podrían estar en una lista negra de spam. Rápidamente empezamos a revisar y a sacar información al respecto y lanzamos este tweet para recibir más feedbacks y poder ampliar datos:

🚨 Alerta Penalizaciones Manuales 🚨 Parece que se están detectando varios casos de penalizaciones manuales por enlaces, me ha llegado por diferentes vías. ¿Tenéis algún caso? ¿Qué tipo de enlaces predominan en el proyecto? #SEO

— iSocialWeb – Alvaro Peña🔺 (@isocialwebseo) January 12, 2020

De esta conversación y otras que se derivaron a posteriori salió un el artículo del amigo Ivan García (un abrazo para todos los Mafiosos SEO), que os comparto a continuación 👇

Penalización manual de Google por enlaces artificiales

En él documenta bastante bien el caso, y creo que tampoco tiene sentido profundizar más, ya que mucho se ha hablado ya de las teorías conspiranoicas, el Update Posonty y chorradas por el estilo. Dejo por cierto también por aquí un vídeo del señor Chuiso (desde mi punto de vista, otro gesto de su buena moral), para debatir con Posonty y que pueda dar su punto de vista, explicarse y la comunidad valore todo el culebrón con más conocimiento de causa y conocimiento de la persona en cuestión:

Tras este culebrón de los enlaces, acusaciones y al final y al cabo datos, que es lo que realmente nos interesa de toda esta historias. Pudimos sacar algunos puntos que nos resultan interesantes y útiles:

- ¿Es una penalización por enlaces en prensa?

NO. Es cierto que hemos visto casos de sites donde abundan los enlaces en prensa y enlaces compartidos, pero también hemos visto otros casos donde no hay ni un sólo enlace de prensa, ni compartidos y han sido penalizados manualmente de igual forma.

- ¿Se produce por una abuso de enlaces de keyword?

Siempre hemos defendido nuestra forma de ver el link building como algo cambiante y adaptativo al sector. De los proyectos que hemos analizado, en algunos casos hay perfiles de enlaces que no hay por donde cogerlos en cuanto a anchoring, con un abuso de enlaces de keyword (para ese sector), pero en otros caso todo lo contrario. Tenemos que intentar huir de modas de anchorings, porcentajes… y empezar a analizar las cosas con datos reales. Por ejemplo, en uno de los casos hay un abuso de enlaces de frase, otra moda sin sentido. ¿Qué probabilidad hay que alguien te enlace con varias palabras y además meta tu marca o tu url y esto de forma repetida hacia un mismo dominio? …. pues eso.

- ¿Entonces por qué ha pasado?

Aquí nadie tiene la verdad absoluta y evidentemente la base de datos con la que contamos es muy pequeña como para sacar conclusiones que se puedan dar como ciertas al 100%. Lo que sí hemos visto es que en todos los casos si miras el perfil de enlaces, ves que hay una alteración manual del mismo derivado de una mala campaña de link building.

Enlaces en perfiles sin tráfico, sin contextualización que no aportan valor al proyecto. Enlaces en contenidos o dominios no contextualizados. Reiteración de patrones… En definitiva prácticas que pueden ser fácilmente identificadas por una máquina o un revisor manual.

- ¿Cómo puedo solucionar este problema?

Aquí la solución pasa por tirar de Ahrefs+GSC y si generas tu propia base de enlaces y ponerse a analizar el perfil de enlaces de tu web penalizada. De aquí puedes empezar a quitar y/o desautorizar aquellos enlaces que no denoten naturalidad en tu estrategia, que no den valor al usuario y simplemente busquen subir la autoridad de tu página, así como los que generen patrones que puedan ser detectables facilmente.

El día oficial de La Purga de las SERPs

Poco tardó Google en volver a tener protagonismo y es que el día siguiente: 13 de Enero de 2020 hizo el anuncio oficial de lo que denominaron en un esfuerzo máximo de originalidad: Core Update Enero 2020

Later today, we are releasing a broad core algorithm update, as we do several times per year. It is called the January 2020 Core Update. Our guidance about such updates remains as we’ve covered before. Please see this blog post for more about that:https://t.co/e5ZQUA3RC6

— Google SearchLiaison (@searchliaison) January 13, 2020

Si queréis saber más sobre este update, como suele ser tradición los amigos de Sistrix lanzaron un artículo comentando la actualización y algunos de los perdedores y vencedores del mismo, os lo comparto también por aquí:

https://www.sistrix.es/blog/google-core-update-enero-2020-primeros-datos-y-analisis/

Es interesante reflejar que Sistrix cuenta con una base de datos enorme, por lo que siempre es recomendable echarle un ojo a las publicaciones y datos, ya que nos puede dar mucha información para ver sus opiniones y/o sacar las nuestras propias.

- ¿En iSocialWeb sacamos algo en claro de este update?

Luego lo documentaremos algo más, pero como bien dice google en el nombre y como se está viendo en las acciones que está aplicando: es un CORE UPDATE. Esto implica que a día de hoy puede afectar a cualquiera de los palos del SEO. De hecho ya estamos viendo que han caído golpes por enlaces y por contenidos.

- ¿Todo han sido penalizaciones negativas?

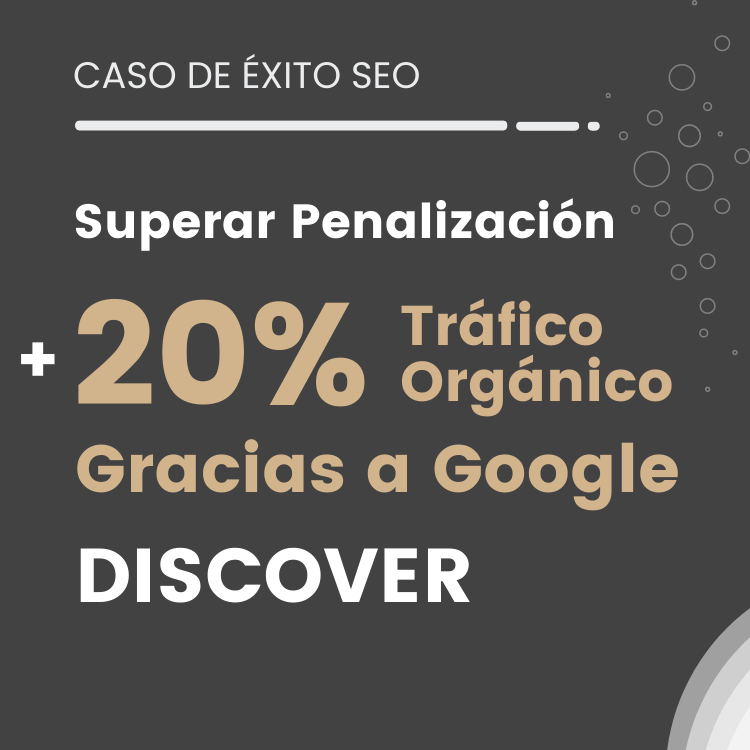

Para nada. En todo update hay perdedores y también ganadores y como bien comentaba Señor Muñoz en este tweet, a veces SIN HACER NADA para merecerlo:

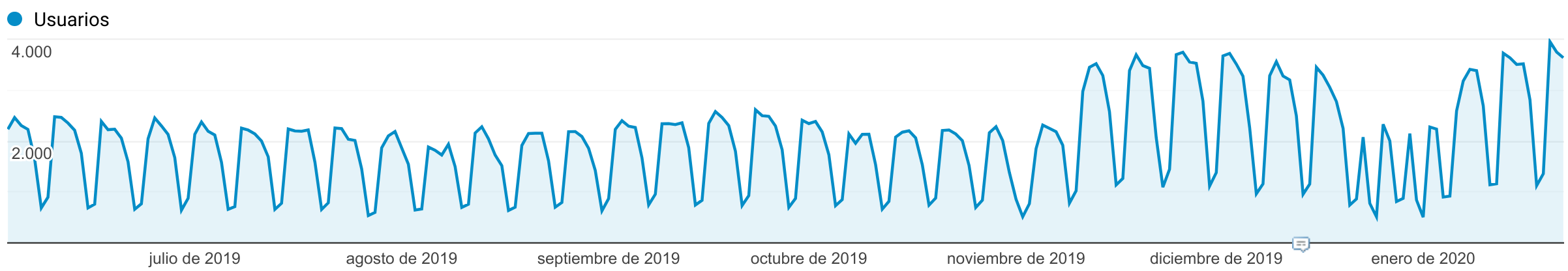

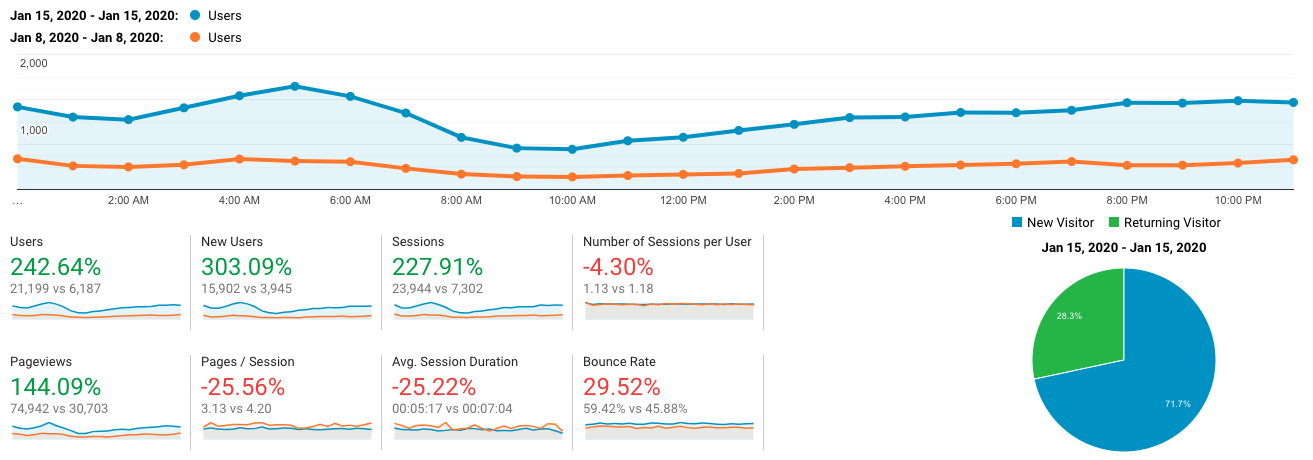

Hoy os vengo a contar un caso de éxito, echad un vistazo a este gráfico. ¿Quereis saber qué hemos hecho? Seguid leyendo. pic.twitter.com/N8XMJtkEgR

— Señor Muñoz (ja/ja) (@senormunoz) January 17, 2020

En el sector salud y webs YMYL hemos visto varios casos de recuperaciones en webs que no se han tocado o que tienen los mismo problema que cuando se llevaron la caída.

En nuestro caso afortunadamente no hemos tenido ningún susto post update y sí algún caso interesante de subida. En este caso haciendo mucho trabajo, lo mismo sin tocar nada habríamos subido, quien sabe:

Bueno, tras estos movimiento, algun@ podía pensar que aquí acababa la fiesta y que todo volvería a la normalidad, pero nada más lejos de la realidad…

La Purga Returns: Penalizaciones manuales por Problemas de SPAM en contenidos

José B.Moreno después del update comentó muy acertadamente, que estos eran los ganadores y perdedores DE MOMENTO. Y es que en el SEO actual todo cambia de un día para otro. Pues como no podía ser de otra forma, hoy día 19 de Enero de 2020 DOMINGO (sí domingo de nuevo hijos de puta). Nos hemos levantado con una nueva oleada de penalizaciones manuales, en este caso por contenidos.

Intentaré hacer de nuevo un poco de crónica de los hechos:

Hoy me he levantado temprano como suelo hacer cualquier día de la semana y he recibido varios comentarios de compañerxs y amigxs, reportándome que habían sido galardonados con una notificación por parte de google por: PROBLEMAS DE SPAM.

Este es un tipo de penalización manual viene por… como se puede leer en el email que manda google para informarte:

«contenido de poca calidad con poco o ningún valor añadido en el sitio web»

Y ojo que por si no lo tienes claro te remarca:

Este problema es grave y provoca que los resultados de búsqueda sean irrelevantes o de poco valor para los usuarios de la Búsqueda de Google, lo que puede afectar negativamente al ranking del sitio web.

Vamos que te ha alegrado el domingo, por si acaso estabas aburrid@.

Como siempre solemos hacer en estos casos, hemos vuelto a compartir la información con el resto de la comunidad vía twitter y linkedin a ver si podíamos ver más casos, documentar y aprender sobre esta nueva purga de google.

🚨 PENALIZACIONES MANUALES 🚨

¿Nueva oleada de penalizaciones manuales? Me han mandado desde dos fuentes distintas, mensajes de penalizaciones manuales por contenido de baja calidad. ¿Alguien más a recibido este mensaje? pic.twitter.com/RCpyj6CsjM— iSocialWeb – Alvaro Peña🔺 (@isocialwebseo) January 19, 2020

Mucha gente pensará que esto sólo pasa en proyecto que hacen SPAM (blackhateros, espineadores de contenidos y mala gente :P), pero ya comenté en mi charla sobre penalizaciones del Indusmedia de 2019, que os comparto aquí:

que a cualquiera nos podría caer una penalización si no estamos encima de los proyectos, no aportamos valor al usuario o no hacemos la vida más fácil a google.

Ejemplos de penalización por contenido SPAM

Os voy a exponer diferentes casos. Este primero de una penalización que hemos vuelto a ver el día de hoy y que ya vimos hace unos cuantos meses:

Ejemplo de penalización por contenidos en sector adulto

Hace un año nos llegaron por diferentes contactos, avisos de muchos webmasters que tenían webs de contenido adulto y que habían recibido penalizaciones manuales por problemas de SPAM en contenidos. Para poder entenderlo mejor, veamos el modelo de negocio y las webs de este tipo:

Normalmente en este tipo de webs, como pasa por ejemplo en algunas webs de gaming (luego veremos otro ejemplo), el contenido de valor de la url, suele ser contenido de terceros que se añade a la web final en forma de embed. Esto puede ser con vídeos, juegos… que incrustas en tu página y le aportas un contenido extra o no para rankearlo, conseguir tráfico y monetizarlo, os pongo una imagen para que lo veáis claro:

pero… ¿De dónde proviene ese contenido?

Por regla general ese es un contenido proveniente de terceros (webs externas que lo comparten con iframes), que ceden sus contenidos con el fin de hacer marca, monetizar internamente con los embebidos o derivar tráfico hacia sus webs. En definitiva un win win para ambas partes.

Entonces… ¿Por qué es un problema esto?

Hemos de tener en cuenta que el contenido que aporta valor a esa intención de búsqueda es el mismo en todas y cada una de las páginas que lo estén embebiendo, es por esto que cada vez que creamos una url nueva con este contenido, estamos duplicando lo mismo que está buscando el usuario y que podría encontrar en el contenido original.

pero… Yo estoy añadiendo contenido único a esta url, textos de más de 400 palabras con keywords optimizadas y super SEO

Aja… si yo busco un video porno de lo que sea, o busco un juego de lo que sea ¿Qué es lo que me aporta valor en la búsqueda? ¿Tu texto super optimizado para SEO o el iframe que resuelve mi intención de búsqueda? Esto además teniendo en cuenta que alguien se lea ese texto.

Al final la calidad del contenido no viene determinada por si tiene 200 o 2000 palabras, sino por el grado de efectividad con la que cumple la intención de búsqueda del usuario.

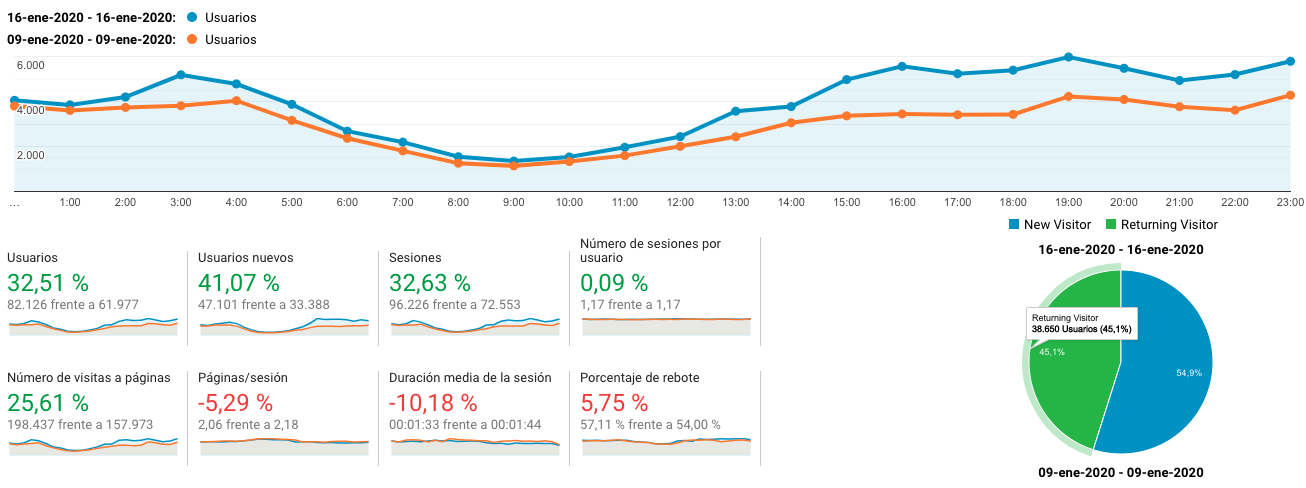

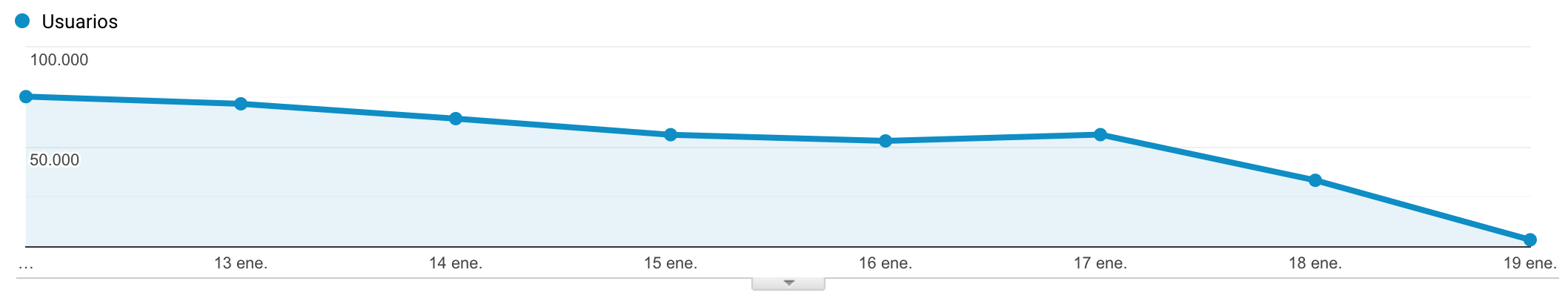

Aquí podéis ver un ejemplo de un caso de una web penalizada por contenido SPAM:

En este caso google ha fulminado prácticamente todo el tráfico de la web, ya que la ha quitado de los resultados hasta para su propia marca. Hace un año vimos múltiples casos y algunos en los que se perdieron cientos o incluso por encima del millón de visitas diarias de la noche a la mañana por este tipo de penalizaciones, y no se han recuperado en muchos casos.

Ejemplo de penalización por contenidos en sector gaming

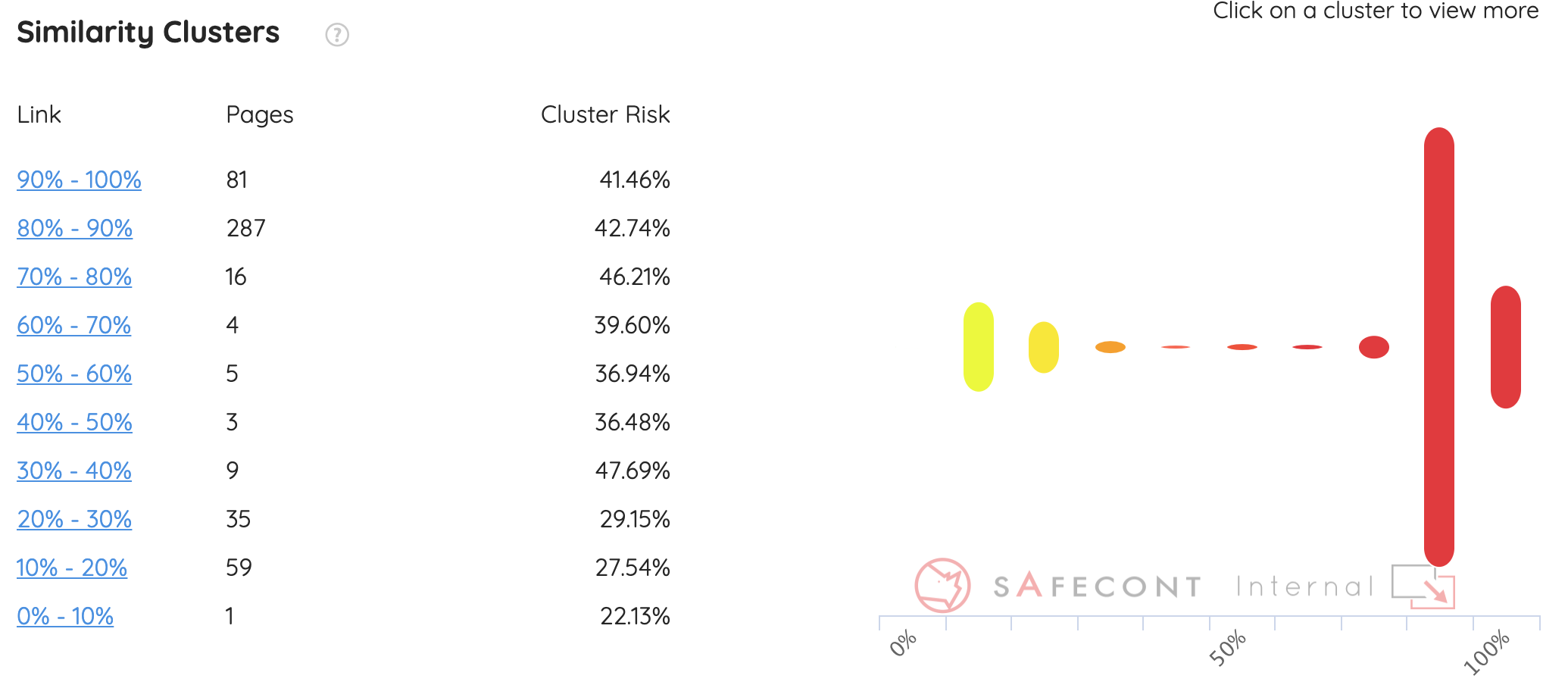

Como comentaba no sólo el adulto se ha visto golpeado por este tipo de penalizaciones, de hecho tampoco el gaming es el único, nos han pasado casos de más sectores como tecnología que no sigue este modelo de negocio. Aquí podéis ver uno de los grandes perdedores de este último update qué patrón de contenidos tiene en su web:

Como veis sobre este análisis parcial de las urls del proyecto, ya vemos un grave problema de similaridad de contenidos derivado de un alto número de página con thin content. Páginas que contienen prácticamente los mismos contenidos y se repiten a lo largo de la web.

¿Vamos a morir tod@s o hay alguna forma de salvar los muebles?

Creo que aquí hay dos puntos principales que deberíamos tener en cuenta de cara a atacar una penalización de este tipo:

1º ¿Aporta algo de valor mi negocio al sector en el que estoy?

2º ¿En qué punto estoy cometiendo el error y cómo puedo solventarlo?

La respuesta de la primera pregunta en muchos casos puede no gustar a los dueños de las webs. Una página de afiliados que simplemente tiene un listado de productos y no da un valor añadido a los posibles compradores y simplemente ejerce de intermediario entre él y amazon. Una web de juegos que copia juegos de una web externa y no aporta más valor al usuario. Una web de memes que recopila imágenes virales que están por medio internet…

Todos estos casos son proyectos que morirán tarde o temprano, porque google cada vez tendrás más datos para detectarlos y no querrá invertir su tiempo ni su dinero, ni el de sus clientes, en pasar por un sitio que puede ahorrarse. A no ser que se reinventen y seas capaz de aportar un valor diferencial que el del simple contenido embebido.

En el caso de la segunda pregunta, si estás convencido que tu web aporta un valor extra al usuario:

Entonces evidentemente puedes solventar el problema y darle una vuelta a la tortilla.

¿Cómo puedo atacar el contenido de baja calidad?

Aquí hay múltiples soluciones más o menos complicadas o laboriosas, pero si quieres una solución rápida seguramente Safecont sea la respuesta más rápida y sencilla.

¿Puedo hacerlo por otras vías?

Por supuesto, antes de esta herramienta también solventábamos este tipo de problemas y vivíamos felices.

¿Por qué es la mejor solución?

No tenemos ningún tipo de interés en vender una herramienta de terceros, no ganamos nada con ello, es un tema de efectividad y eficiencia. Si quiero detectar enlaces usaré GSC y Ahrefs, porque es la mejor herramienta que lo hace. Si quiero analizar de forma rápida y con poco gasto los principales errores técnicos de una web usará Screaming Frog. Y con los contenidos Safecont es la herramienta que mejor funciona.

¿Cómo puedo solucionarlo?

Ojo, que esto no quiere decir que vayas a usar esta herramienta y te solucione el problema. Esto es la herramienta, el cerebro y el razonamiento lo tiene que poner cada profesional. Gracias a esta herramienta podremos ver patrones o agrupaciones de contenidos con problema de thin content, después de esto tendremos que analizar si estos son o no perjudiciales para nuestra web. Necesitaremos ver datos analíticos de estos clusters o urls y en base a ello decidir cómo actuamos para solventarlo.

¿Y a ti? ¿Te ha golpeado este update? Cuéntanos tu caso en los comentarios o en twitter o linkedin

Artículos Relacionados

Agencia especializada en ingeniería del marketing digital. Adquisición de tráfico, análisis y optimización de resultados.

- isocialwebhttps://www.isocialweb.agency/autor/isocialweb/

- isocialwebhttps://www.isocialweb.agency/autor/isocialweb/

- isocialwebhttps://www.isocialweb.agency/autor/isocialweb/

- isocialwebhttps://www.isocialweb.agency/autor/isocialweb/